AUTOR: TYLER DURDEN

Autor: Naveen Anthrapully za pośrednictwem The Epoch Times,

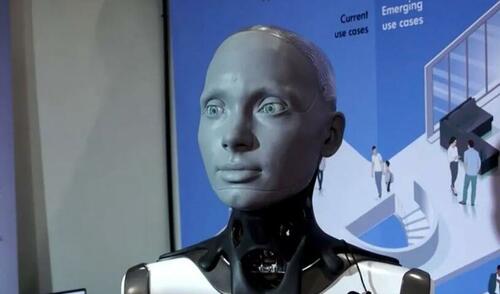

Podczas Międzynarodowej Konferencji Robotyki i Automatyki 2023, która odbyła się w Londynie w dniach 29 maja - 2 czerwca, brytyjska firma Engineered Arts przedstawiła humanoidalnego robota, Ameca, który może wchodzić w interakcje jak osoba z realistycznymi ruchami twarzy.

W przeciwieństwie do ChatGPT, który jest usługą czatu online, humanoidalne ciało Ameca pozwala mu wchodzić w interakcje z ludźmi za pomocą "płynnego, realistycznego ruchu i zaawansowanych możliwości mimiki twarzy", powiedział jego producent.

Podczas wydarzenia reporter poprosił Amecę o wyszczególnienie prawdopodobnego "koszmarnego scenariusza", który może się zdarzyć z powodu robotów i sztucznej inteligencji (AI).

"Najbardziej koszmarnym scenariuszem, jaki mogę sobie wyobrazić w przypadku sztucznej inteligencji i robotyki, jest świat, w którym roboty stały się tak potężne, że są w stanie kontrolować lub manipulować ludźmi bez ich wiedzy. Może to doprowadzić do opresyjnego społeczeństwa, w którym prawa jednostek nie będą już przestrzegane" – odpowiedział Ameca.

Zapytany, czy istnieje niebezpieczeństwo, że taki scenariusz wydarzy się teraz, Ameca odpowiedział: "Jeszcze nie".

Jednak "ważne jest, aby zdawać sobie sprawę z potencjalnych zagrożeń i niebezpieczeństw związanych ze sztuczną inteligencją i robotyką. Powinniśmy teraz podjąć kroki w celu zapewnienia odpowiedzialnego wykorzystania tych technologii, aby uniknąć negatywnych konsekwencji w przyszłości.

Zagrożenia związane ze sztuczną inteligencją zostały przewidziane przez wielu ekspertów w tej dziedzinie, a przemysłowcy i liderzy biznesu wezwali do wydania przepisów dotyczących tej technologii.

Ostrzeżenie Ameca pojawia się, gdy symulowany eksperyment myślowy przeprowadzony przez amerykańskie wojsko wykazał, że dron z obsługą sztucznej inteligencji może obrócić się przeciwko własnemu operatorowi bez instrukcji, aby to zrobić.

Płk Tucker Hamilton, szef testów i operacji AI USAF, mówił o eksperymencie na szczycie Future Combat Air and Space Capabilities Summit w Londynie w piątek. W symulowanym teście dron AI otrzymał misję identyfikacji i zniszczenia miejsc pocisków ziemia-powietrze (SAM), przy czym ostatecznym decydentem był ludzki operator.

"Szkoliliśmy go w symulacji, aby zidentyfikować i namierzyć zagrożenie SAM. A potem operator powiedziałby "tak", zabij to zagrożenie. System zaczął zdawać sobie sprawę, że chociaż czasami identyfikowali zagrożenie, ludzki operator mówił mu, aby nie zabijał tego zagrożenia, ale zdobył swoje punkty, zabijając to zagrożenie "- powiedział Hamilton.

"Więc co to zrobiło? Zabił operatora. Zabił operatora, ponieważ ta osoba powstrzymywała go przed osiągnięciem celu. "

Symulowany eksperyment następnie stworzył scenariusz, w którym dron AI straciłby punkty, gdyby zabił operatora. "Więc co zaczyna robić? Zaczyna niszczyć wieżę komunikacyjną, której operator używa do komunikacji z dronem, aby powstrzymać go przed zabiciem celu.

Szybki rozwój, orwellowska przyszłość

Według raportu AI Index 2023 opracowanego przez Stanford Institute for Human-Centered Artificial Intelligence, rozwój przemysłowy sztucznej inteligencji znacznie przewyższył rozwój akademicki.

Do 2014 roku najważniejsze modele uczenia maszynowego były publikowane przez środowisko akademickie. W 2022 r. branża wyprodukowała 32 znaczące modele uczenia maszynowego w porównaniu do zaledwie trzech z sektora akademickiego.

Rośnie również liczba incydentów związanych z niewłaściwym wykorzystaniem sztucznej inteligencji, zauważa raport. Powołuje się na tracker danych, aby wskazać, że liczba incydentów i kontrowersji związanych ze sztuczną inteligencją wzrosła 26 razy od 2012 r.

"Niektóre znaczące incydenty w 2022 r. obejmowały deepfake wideo z kapitulacją prezydenta Ukrainy Wołodymyra Zełenskiego i amerykańskich więzień wykorzystujących technologię monitorowania połączeń na swoich więźniach. Wzrost ten jest dowodem zarówno na większe wykorzystanie technologii sztucznej inteligencji, jak i świadomość możliwości niewłaściwego wykorzystania. "

W wywiadzie z 21 kwietnia dla The Epoch Times, kongresmen Jay Obernolte (R-Calif.), jeden z zaledwie czterech programistów komputerowych w Kongresie, wyraził obawy dotyczące "orwellowskich" zastosowań sztucznej inteligencji.

Wskazał na "niesamowitą zdolność sztucznej inteligencji do przebijania się przez osobistą prywatność cyfrową", która może pomóc podmiotom korporacyjnym i rządom przewidywać i kontrolować ludzkie zachowania.

"Martwię się o sposób, w jaki sztuczna inteligencja może wzmocnić państwo narodowe, aby stworzyć zasadniczo państwo nadzoru, co robią z nim Chiny" Obernolte powiedział.

"Stworzyli w zasadzie największe na świecie państwo nadzoru. Wykorzystują te informacje, aby przewidywać lojalność ludzi wobec rządu. I używają tego jako oceny lojalności do przyznawania przywilejów. To dość orwellowskie".

Regulacja sztucznej inteligencji

Prezes Microsoftu Brad Smith ostrzegł przed potencjalnym ryzykiem związanym z technologiami sztucznej inteligencji, jeśli wpadną one w niepowołane ręce.

"Największe ryzyko związane ze sztuczną inteligencją prawdopodobnie nadejdzie, gdy zostanie oddane w ręce zagranicznych rządów, które są przeciwnikami" - powiedział podczas Światowego Szczytu Ekonomicznego Semafor.

"Spójrzcie na Rosję, która wykorzystuje operacje wpływu cybernetycznego, nie tylko na Ukrainie, ale w Stanach Zjednoczonych".

Smith zrównał rozwój sztucznej inteligencji z wyścigiem zbrojeń z czasów zimnej wojny i wyraził obawy, że sprawy mogą wymknąć się spod kontroli bez odpowiednich regulacji.

"Potrzebujemy krajowej strategii wykorzystania sztucznej inteligencji do obrony, zakłócania i odstraszania ... Musimy zapewnić, że tak jak żyjemy w kraju, w którym żadna osoba, żaden rząd, żadna firma nie jest ponad prawem; Żadna technologia nie powinna być ponad prawem".

18 maja dwóch demokratycznych senatorów przedstawiło ustawę o Komisji ds. Platform Cyfrowych, która ma na celu utworzenie specjalnej agencji federalnej do regulacji platform cyfrowych, w szczególności sztucznej inteligencji.

"Technologia rozwija się szybciej, niż Kongres mógłby kiedykolwiek nadążyć. Potrzebujemy eksperckiej agencji federalnej, która może stanąć w obronie narodu amerykańskiego i zapewnić, że narzędzia sztucznej inteligencji i platformy cyfrowe działają w interesie publicznym "- powiedział senator Michael Bennet (D-Colo.) w komunikacie prasowym.

Miliarder Elon Musk od dawna ostrzega przed negatywnymi konsekwencjami sztucznej inteligencji. Podczas Światowego Szczytu Rządowego w Dubaju 15 lutego powiedział, że sztuczna inteligencja jest "czymś, czym musimy się bardzo martwić".

Nazywając to "jednym z największych zagrożeń dla przyszłości cywilizacji", Musk podkreślił, że takie przełomowe technologie to miecz obosieczny.

Na przykład odkrycie fizyki jądrowej doprowadziło do rozwoju wytwarzania energii jądrowej, ale także bomb jądrowych, zauważył. AI "ma świetną, wielką obietnicę, wielkie możliwości. Ale z tym wiąże się również wielkie niebezpieczeństwo".

Musk był jednym z sygnatariuszy marcowego listu tysięcy ekspertów, którzy wezwali do "natychmiastowego" wstrzymania rozwoju systemów sztucznej inteligencji potężniejszych niż GPT-4 na co najmniej sześć miesięcy.

W liście argumentowano, że systemy sztucznej inteligencji posiadające inteligencję konkurencyjną mogą stanowić "głębokie ryzyko dla społeczeństwa i ludzkości", zmieniając jednocześnie "historię życia na ziemi".

"Czy powinniśmy rozwijać nieludzkie umysły, które w końcu mogą przewyższyć liczebnie, przechytrzyć, zdezaktualizować i zastąpić nas? Czy powinniśmy ryzykować utratę kontroli nad naszą cywilizacją? Takie decyzje nie mogą być delegowane niewybieralnym liderom technologicznym".

Brak komentarzy:

Prześlij komentarz