AUTOR: TYLER DURDEN

Autor: Brett Wilkins via Common Dreams,

W imię "ochrony przyszłych pokoleń przed potencjalnie niszczycielskimi konsekwencjami" dwupartyjna grupa amerykańskich prawodawców wprowadziła w środę przepisy mające na celu uniemożliwienie sztucznej inteligencji wystrzelenia broni jądrowej bez znaczącej kontroli człowieka.

The Block Nuclear Launch by Autonomous Artificial Intelligence Act - wprowadzony przez senatora Eda Markeya (D-Mass.) i reps. Ted Lieu (D-Calif.), Don Beyer (D-Va.) i Ken Buck (R-Colo.) – twierdzi, że "żadna decyzja o wystrzeleniu broni jądrowej nie powinna być podejmowana" przez sztuczną inteligencję.

Proponowane ustawodawstwo uznaje, że Przegląd Postawy Nuklearnej Pentagonu w 2022 r. stwierdza, że obecna polityka USA polega na "utrzymywaniu człowieka" w pętli "dla wszystkich działań krytycznych dla informowania i wykonywania decyzji prezydenta o rozpoczęciu i zakończeniu zatrudnienia broni jądrowej".

Ustawa skodyfikowałaby tę politykę, tak aby żadne fundusze federalne nie mogły być wykorzystywane "do wystrzelenia broni jądrowej [lub] wyboru lub zaangażowania celów w celu wystrzelenia" broni nuklearnej.

"Ponieważ żyjemy w coraz bardziej cyfrowej erze, musimy zapewnić, że ludzie mają moc samą do dowodzenia, kontrolowania i uruchamiania broni jądrowej - nie robotów" - zapewnił Markey w oświadczeniu. "Musimy trzymać ludzi w pętli przy podejmowaniu decyzji o życiu lub śmierci, aby użyć śmiercionośnej siły, szczególnie w przypadku naszej najbardziej niebezpiecznej broni".

Buck argumentował, że "podczas gdy wojskowe wykorzystanie sztucznej inteligencji przez USA może być odpowiednie dla zwiększenia celów bezpieczeństwa narodowego, wykorzystanie sztucznej inteligencji do rozmieszczania broni jądrowej bez ludzkiego łańcucha dowodzenia i kontroli jest lekkomyślne, niebezpieczne i powinno być zabronione".

Według raportu AI Index 2023 – corocznej oceny opublikowanej na początku tego miesiąca przez Stanford Institute for Human-Centered Artificial Intelligence – 36% ankietowanych ekspertów AI obawia się, że zautomatyzowane systemy "mogą spowodować katastrofę na poziomie jądrowym".

Raport został opublikowany po lutowej ocenie Stowarzyszenia Kontroli Zbrojeń, grupy rzeczniczej, że sztuczna inteligencja i inne nowe technologie, w tym śmiercionośne autonomiczne systemy broni i pociski hipersoniczne, stanowią potencjalnie egzystencjalne zagrożenie, które podkreśla potrzebę środków spowalniających tempo zbrojenia.

"Podczas gdy wszyscy próbujemy zmagać się z tempem, w jakim sztuczna inteligencja przyspiesza, przyszłość sztucznej inteligencji i jej rola w społeczeństwie pozostaje niejasna" – powiedział Lieu w oświadczeniu wprowadzającym nową ustawę.

"Naszym zadaniem jako członków Kongresu jest odpowiedzialne przewidywanie, jeśli chodzi o ochronę przyszłych pokoleń przed potencjalnie niszczycielskimi konsekwencjami" - kontynuował. "Dlatego z przyjemnością przedstawiam dwupartyjny, dwuizbowy Block Nuclear Launch by Autonomous AI Act, który zapewni, że bez względu na to, co stanie się w przyszłości, człowiek ma kontrolę nad użyciem broni jądrowej - nie robota".

"Sztuczna inteligencja nigdy nie zastąpi ludzkiego osądu, jeśli chodzi o wystrzeliwanie broni jądrowej" - dodał Lieu.

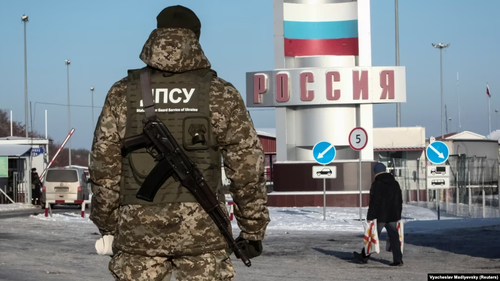

Podczas gdy dziesiątki krajów popierają Traktat o zakazie broni jądrowej, żadne z dziewięciu światowych mocarstw nuklearnych, w tym Stany Zjednoczone, nie podpisało go, a inwazja Rosji na Ukrainę obudziła obawy przed konfliktem nuklearnym, które były w dużej mierze uśpione od czasów zimnej wojny.