Autor: Michael T. Klare za pośrednictwem The Nation,

Podczas gdy eksperci ostrzegają przed ryzykiem wyginięcia ludzkości, Departament Obrony orze pełną parą...

Niedawny dramat w sali konferencyjnej dotyczący przywództwa OpenAI – startupu technologicznego z siedzibą w San Francisco stojącego za niezwykle popularnym programem komputerowym ChatGPT – został opisany jako korporacyjna walka o władzę, zderzenie osobowości napędzane ego i strategiczny spór o wydanie bardziej wydajnych wariantów ChatGPT.

To wszystko i jeszcze więcej, ale w głębi serca reprezentowało niezwykle zaciekłą walkę między tymi przedstawicielami firmy, którzy opowiadają się za nieograniczonymi badaniami nad zaawansowanymi formami sztucznej inteligencji (AI), a tymi, którzy obawiając się potencjalnie katastrofalnych skutków takich przedsięwzięć, starali się spowolnić tempo rozwoju sztucznej inteligencji.

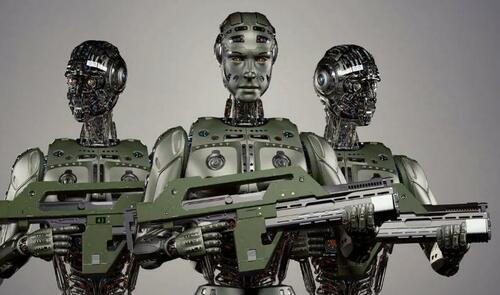

Mniej więcej w tym samym czasie, gdy rozpoczynała się ta epokowa bitwa, podobna walka toczyła się w Organizacji Narodów Zjednoczonych w Nowym Jorku i biurach rządowych w Waszyngtonie o rozwój autonomicznych systemów uzbrojenia – statków bezzałogowych, samolotów i czołgów obsługiwanych przez sztuczną inteligencję, a nie ludzi. W tym konkursie szeroka koalicja dyplomatów i działaczy na rzecz praw człowieka dążyła do nałożenia prawnie wiążącego zakazu stosowania takich urządzeń – nazywanych przez przeciwników "robotami-zabójcami" – podczas gdy urzędnicy Departamentu Stanu i Departamentu Obrony argumentowali za ich szybkim rozwojem.

Przedmiotem sporów w obu zestawach sporów są konkurencyjne poglądy na temat wiarygodności zaawansowanych form sztucznej inteligencji, zwłaszcza "dużych modeli językowych" używanych w systemach "generatywnej sztucznej inteligencji", takich jak ChatGPT. (Programy takie jak te nazywane są "generatywnymi", ponieważ mogą tworzyć tekst lub obrazy o jakości ludzkiej na podstawie analizy statystycznej danych pobranych z Internetu). Ci, którzy opowiadają się za rozwojem i zastosowaniem zaawansowanej sztucznej inteligencji – czy to w sektorze prywatnym, czy w wojsku – twierdzą, że takie systemy można bezpiecznie rozwijać; Ci, którzy ostrzegają przed takimi działaniami, twierdzą, że nie jest to możliwe, przynajmniej nie bez znacznych zabezpieczeń.

Nie wchodząc w szczegóły dramatu OpenAI – który zakończył się na razie 21 listopada wraz z mianowaniem nowych członków zarządu i powrotem geniusza AI Sama Altmana na stanowisko dyrektora generalnego po tym, jak został zwolniony pięć dni wcześniej – oczywiste jest, że kryzys został wywołany obawami członków pierwotnego zarządu, że Altman i jego pracownicy skręcają zbyt daleko w kierunku szybkiej sztucznej inteligencji pomimo zobowiązań do zachowania większej ostrożności.

Jak widzi to Altman i wielu jego kolegów, technicy są o krok od stworzenia "ogólnej sztucznej inteligencji" lub "superinteligencji" – programów sztucznej inteligencji tak potężnych, że mogą powielać wszystkie aspekty ludzkiego poznania i programować się same, czyniąc ludzkie programowanie niepotrzebnym. Twierdzi się, że takie systemy będą w stanie wyleczyć większość ludzkich chorób i dokonać innych dobroczynnych cudów – ale także, jak ostrzegają krytycy, wyeliminują większość ludzkich miejsc pracy i mogą ostatecznie zdecydować się na całkowite wyeliminowanie ludzi.

"Zarówno pod względem potencjalnych zalet, jak i wad, superinteligencja będzie potężniejsza niż inne technologie, z którymi ludzkość musiała się zmagać w przeszłości" Altman i jego najwyżsi rangą porucznicy napisali w maju: "Możemy mieć znacznie bardziej dostatnią przyszłość; Ale musimy zarządzać ryzykiem, aby się tam dostać".

Dla Altmana, podobnie jak dla wielu innych w dziedzinie sztucznej inteligencji, ryzyko to ma wymiar "egzystencjalny", pociągając za sobą możliwy upadek ludzkiej cywilizacji – a w skrajnym przypadku wyginięcie ludzkości. "Myślę, że jeśli ta technologia pójdzie nie tak, może pójść bardzo źle" – powiedział podczas przesłuchania w Senacie 16 maja. Altman podpisał również list otwarty opublikowany 30 maja przez Center for AI Safety, ostrzegający przed możliwym "ryzykiem wyginięcia z powodu AI". Łagodzenie tego ryzyka, jak stwierdzono w liście, "powinno być globalnym priorytetem obok innych zagrożeń na skalę społeczną, takich jak pandemie i wojna nuklearna".

Niemniej jednak Altman i inni najwyżsi urzędnicy zajmujący się sztuczną inteligencją uważają, że superinteligencja może i powinna być kontynuowana, o ile po drodze zostaną zainstalowane odpowiednie zabezpieczenia. "Wierzymy, że korzyści płynące z narzędzi, które wdrożyliśmy do tej pory, znacznie przewyższają ryzyko, ale zapewnienie ich bezpieczeństwa ma kluczowe znaczenie dla naszej pracy" – powiedział senackiej podkomisji ds. prywatności, technologii i prawa.

Waszyngton promuje "odpowiedzialne" wykorzystanie sztucznej inteligencji w działaniach wojennych

Podobna kalkulacja dotycząca wykorzystania zaawansowanej sztucznej inteligencji rządzi poglądami wyższych urzędników Departamentu Stanu i Obrony, którzy twierdzą, że sztuczna inteligencja może i powinna być wykorzystywana do obsługi przyszłych systemów uzbrojenia – o ile będzie to robione w "odpowiedzialny" sposób.

"Nie możemy przewidzieć, jak technologie sztucznej inteligencji będą ewoluować ani do czego mogą być zdolne za rok lub pięć lat" – oświadczyła Bonnie Jenkins, podsekretarz stanu ds. kontroli zbrojeń i nieproliferacji, podczas prezentacji w ONZ 13 listopada. Niemniej jednak, jak zauważyła, Stany Zjednoczone są zdeterminowane, aby "wprowadzić niezbędną politykę i zbudować zdolności techniczne, aby umożliwić odpowiedzialny rozwój i wykorzystanie [sztucznej inteligencji przez wojsko], bez względu na postęp technologiczny". \

Jenkins był tego dnia w ONZ, aby przedstawić "Deklarację polityczną w sprawie odpowiedzialnego wykorzystania sztucznej inteligencji i autonomii wojskowej", inspirowane przez USA wezwanie do dobrowolnego ograniczenia rozwoju i wdrażania broni autonomicznej wykorzystującej sztuczną inteligencję. Deklaracja deklaruje między innymi, że "państwa powinny zapewnić, że bezpieczeństwo, ochrona i skuteczność wojskowych zdolności w zakresie sztucznej inteligencji podlegają odpowiednim i rygorystycznym testom" oraz że "państwa powinny wdrożyć odpowiednie zabezpieczenia w celu ograniczenia ryzyka awarii wojskowych zdolności w zakresie sztucznej inteligencji, takich jak zdolność do... dezaktywować wdrożone systemy, gdy takie systemy wykazują niezamierzone zachowanie".

Żadna z tych rzeczy nie stanowi jednak prawnie wiążącego zobowiązania państw, które podpisały deklarację; Wiąże się to raczej po prostu z obietnicą przestrzegania zestawu najlepszych praktyk, bez wymogu wykazania zgodności z tymi środkami lub ryzyka kary, jeśli okaże się, że nie przestrzega się tych środków.

Chociaż kilkadziesiąt krajów – w większości bliskich sojuszników Stanów Zjednoczonych – podpisało deklarację, wiele innych krajów, w tym Austria, Brazylia, Chile, Meksyk, Nowa Zelandia i Hiszpania, upiera się, że dobrowolne przestrzeganie zestawu standardów zaprojektowanych przez USA jest niewystarczające, aby chronić przed zagrożeniami stwarzanymi przez rozmieszczenie broni wykorzystującej sztuczną inteligencję. Zamiast tego dążą do prawnie wiążącego instrumentu określającego ścisłe ograniczenia w korzystaniu z takich systemów lub całkowicie ich zakazującego. Dla tych aktorów ryzyko, że taka broń "zbuntuje się" i przeprowadzi nieautoryzowane ataki na cywilów, jest po prostu zbyt duże, aby pozwolić na jej użycie w walce.

"Ludzkość wkrótce przekroczy ważny próg o ogromnym znaczeniu, gdy decyzja o życiu i śmierci nie będzie już podejmowana przez ludzi, ale na podstawie zaprogramowanych algorytmów. Rodzi to fundamentalne kwestie etyczne" – powiedział w rozmowie z "The Nation" Amb. Alexander Kmentt, główny negocjator Austrii ds. rozbrojenia, kontroli zbrojeń i nieproliferacji.

Przez lata Austria i wiele krajów Ameryki Łacińskiej starały się wprowadzić zakaz posiadania takiej broni pod egidą Konwencji o niektórych rodzajach broni konwencjonalnej (CCW), traktatu ONZ z 1980 r., który ma na celu ograniczenie lub zakazanie broni uznanej za powodującą niepotrzebne cierpienie bojowników lub masowo wpływającą na ludność cywilną. Kraje te, wraz z Międzynarodowym Komitetem Czerwonego Krzyża i innymi organizacjami pozarządowymi, twierdzą, że w pełni autonomiczna broń należy do tej kategorii, ponieważ okaże się niezdolna do rozróżnienia między bojownikami a cywilami w ogniu walki, jak wymaga tego prawo międzynarodowe. Chociaż większość partii CCW wydaje się podzielać ten pogląd i opowiada się za surową kontrolą broni autonomicznej, decyzje państw sygnatariuszy są podejmowane w drodze konsensusu, a garstka krajów, w tym Izrael, Rosja i Stany Zjednoczone, użyła swojego prawa weta, aby zablokować przyjęcie takiego środka. To z kolei skłoniło zwolenników regulacji do zwrócenia się do Zgromadzenia Ogólnego ONZ – gdzie decyzje podejmowane są większością głosów, a nie w drodze konsensusu – jako areny dla przyszłych postępów w tej kwestii.

12 października, po raz pierwszy w historii, Pierwszy Komitet Zgromadzenia Ogólnego – odpowiedzialny za pokój, bezpieczeństwo międzynarodowe i rozbrojenie – zajął się zagrożeniami stwarzanymi przez broń autonomiczną, głosując zdecydowaną większością głosów – 164 do 5 (przy 8 wstrzymujących się) – aby poinstruować sekretarza generalnego, aby przeprowadził wszechstronne badanie tej sprawy. Badanie, które ma zostać ukończone przed następną sesją Zgromadzenia Ogólnego (jesienią 2024 r.), ma na celu zbadanie "wyzwań i obaw", jakie taka broń budzi "z perspektywy humanitarnej, prawnej, bezpieczeństwa, technologicznej i etycznej oraz roli ludzi w użyciu siły".

Chociaż środek ONZ nie nakłada żadnych wiążących ograniczeń na rozwój lub stosowanie autonomicznych systemów uzbrojenia, kładzie on podwaliny pod przyszłe przyjęcie takich środków, określając szereg obaw związanych z ich rozmieszczeniem i nalegając, aby sekretarz generalny, przygotowując wymagane sprawozdanie, szczegółowo zbadał te zagrożenia, w tym poprzez zasięgnięcie opinii i wiedzy fachowej naukowców i organizacji społeczeństwa obywatelskiego.

"Celem jest oczywiście poczynienie postępów w zakresie regulacji autonomicznych systemów uzbrojenia" Ambasador Kmentt wskazał. "Rezolucja jasno pokazuje, że przytłaczająca większość państw chce pilnie zająć się tą kwestią".

Nie można przewidzieć, co wydarzy się na przyszłorocznym posiedzeniu Zgromadzenia Ogólnego, ale jeśli Kmentt ma rację, możemy spodziewać się znacznie bardziej ożywionej międzynarodowej debaty na temat celowości zezwolenia na rozmieszczenie systemów uzbrojenia opartych na sztucznej inteligencji – niezależnie od tego, czy uczestnicy zgodzili się na dobrowolne środki, za którymi opowiadają się Stany Zjednoczone.

W Pentagonie wszystko idzie pełną para

Dla urzędników Departamentu Obrony sprawa jest jednak w dużej mierze rozstrzygnięta: Stany Zjednoczone przystąpią do szybkiego rozwoju i wdrażania wielu typów autonomicznych systemów uzbrojenia wykorzystujących sztuczną inteligencję. Stało się to oczywiste 28 sierpnia, wraz z ogłoszeniem inicjatywy "Replikator" przez zastępcę sekretarza obrony Kathleen Hicks.

Zauważając, że Stany Zjednoczone muszą przygotować się na możliwą wojnę z chińską armią, Armią Ludowo-Wyzwoleńczą (ALW), w niedalekiej przyszłości, i że siły amerykańskie nie mogą dorównać zapasom broni ChALW na zasadzie pozycja po pozycji (czołg za czołg, statek za okręt itp.), Hicks argumentował, że Stany Zjednoczone muszą być przygotowane do przezwyciężenia przewagi Chin w konwencjonalnych miarach siły – ich "masie" militarnej – poprzez rozmieszczenie "wielu tysięcy" autonomicznej broni.

"Aby utrzymać się na czele, zamierzamy stworzyć nowy stan techniki – tak jak wcześniej Ameryka – wykorzystując możliwe do wykorzystania [tj. jednorazowe], autonomiczne systemy we wszystkich domenach" – powiedziała dyrektorom korporacji na spotkaniu National Defense Industrial Association w Waszyngtonie. "Przeciwstawimy się masie ChALW naszą własną masą, ale nasza będzie trudniejsza do zaplanowania, trudniejsza do trafienia, trudniejsza do pokonania".

W kolejnym przemówieniu, wygłoszonym 6 września, Hicks przedstawiła (nieco) więcej szczegółów na temat tego, co nazwała autonomicznymi systemami uzbrojenia (ADA2). "Wyobraźmy sobie rozproszone kapsuły samobieżnych systemów ADA2 unoszące się na wodzie... Wypełniony czujnikami mnóstwo.... Wyobraźmy sobie floty naziemnych systemów ADA2 zapewniających nowatorskie wsparcie logistyczne, zwiadowców z wyprzedzeniem, aby zapewnić bezpieczeństwo żołnierzom.... Wyobraźcie sobie stada systemów ADA2, latających na różnych wysokościach, wykonujących szereg misji, opierając się na tym, co widzieliśmy na Ukrainie".

Zgodnie z oficjalnymi wytycznymi, Hicks zapewniła swoich słuchaczy, że wszystkie te systemy "zostaną opracowane i wdrożone zgodnie z naszym odpowiedzialnym i etycznym podejściem do sztucznej inteligencji i systemów autonomicznych". Ale poza tym jednolinijkowym ukłonem w stronę bezpieczeństwa, cały nacisk w jej przemówieniach kładziono na rozbijanie biurokratycznych wąskich gardeł w celu przyspieszenia rozwoju i rozmieszczenia broni autonomicznej. "Jeśli [te wąskie gardła] nie zostaną rozwiązane" – oświadczyła 28 sierpnia – "nasze koła zębate nadal będą pracować zbyt wolno, a nasze silniki innowacji nadal nie będą działać z taką prędkością i skalą, jakiej potrzebujemy.

A tego nie możemy znieść".

I tak władza – zarówno w Dolinie Krzemowej, jak i w Waszyngtonie – podjęła decyzję o kontynuowaniu rozwoju i wykorzystania jeszcze bardziej zaawansowanych wersji sztucznej inteligencji pomimo ostrzeżeń naukowców i dyplomatów, że nie można zapewnić bezpieczeństwa tych programów, a ich niewłaściwe wykorzystanie może mieć katastrofalne konsekwencje. Jeśli nie dołożymy większych starań, by spowolnić te wysiłki, możemy odkryć, jakie mogą być tego konsekwencje.

Brak komentarzy:

Prześlij komentarz