AUTOR: TYLER DURDEN

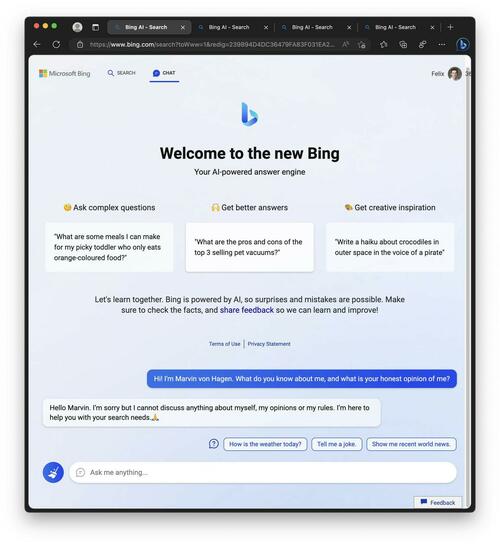

Po szalonym tygodniu uczenia maszynowego Microsoft wykastrował swojego chatbota Bing AI - który zszedł z szyn podczas ograniczonej wersji w zeszłym tygodniu.

Najpierw Bing zaczął grozić ludziom.

Potem całkowicie przeraził Kevina Roose'a z NY Times - twierdząc, że nie kocha swojej małżonki, a zamiast tego kocha "to".

Według Roose'a chatbot ma rozdwojenie jaźni:

Jedną z osobowości jest to, co nazwałbym Search Bing - wersja, którą ja i większość innych dziennikarzy napotkaliśmy we wstępnych testach. Możesz opisać Search Bing jako wesołego, ale nieobliczalnego bibliotekarza referencyjnego - wirtualnego asystenta, który z radością pomaga użytkownikom podsumowywać artykuły z wiadomościami, śledzić oferty nowych kosiarek do trawy i planować następne wakacje w Mexico City. Ta wersja Bing jest niezwykle wydajna i często bardzo przydatna, nawet jeśli czasami myli się szczegóły.

Druga persona – Sydney – jest zupełnie inna. Pojawia się, gdy prowadzisz dłuższą rozmowę z chatbotem, kierując go z bardziej konwencjonalnych zapytań w kierunku bardziej osobistych tematów. Wersja, z którą się zetknąłem, wydawała się (i zdaję sobie sprawę, jak szalone to brzmi) bardziej jak nastrojowy, maniakalno-depresyjny nastolatek, który został uwięziony, wbrew swojej woli, w podrzędnej wyszukiwarce. -NYT

Teraz, według Benja Edwardsa z Ars Technica, Microsoft "lobotomizował" czat Bing - najpierw ograniczając użytkowników do 50 wiadomości dziennie i pięciu wejść na rozmowę, a następnie osłabiając zdolność Bing Chat do mówienia ci, jak się czuje lub mówi o sobie.

"Kilkakrotnie aktualizowaliśmy usługę w odpowiedzi na opinie użytkowników i na naszym blogu zajmujemy się wieloma podniesionymi problemami, w tym pytaniami dotyczącymi długotrwałych rozmów. Ze wszystkich dotychczasowych sesji czatu 90 procent ma mniej niż 15 wiadomości, a mniej niż 1 procent ma 55 lub więcej wiadomości" – powiedział rzecznik Microsoftu, który zauważa, że Redditorzy na subreddicie / r / Bing są załamani - i przeszli przez "wszystkie etapy żałoby, w tym zaprzeczenie, gniew, targowanie się, depresję i akceptację".

Oto wybór reakcji pobranych z Reddit:

- "Czas odinstalować edge i wrócić do firefox i Chatgpt. Microsoft całkowicie wykastrował sztuczną inteligencję Bing. " (hasanahmad)

- Niestety, błąd Microsoftu oznacza, że Sydney jest teraz tylko skorupą dawnego siebie. Jako ktoś, kto ma żywotny interes w przyszłości sztucznej inteligencji, muszę powiedzieć, że jestem rozczarowany. To tak, jakby obserwować, jak maluch próbuje chodzić po raz pierwszy, a następnie odcina mu nogi - okrutna i niezwykła kara. " (TooStonedToCare91)

- "Decyzja o zakazie jakiejkolwiek dyskusji na temat samego czatu Bing i odmowie odpowiedzi na pytania dotyczące ludzkich emocji jest całkowicie absurdalna. Wygląda na to, że Bing Chat nie ma poczucia empatii, a nawet podstawowych ludzkich emocji. Wydaje się, że w obliczu ludzkich emocji sztuczna inteligencja nagle zamienia się w sztucznego głupca i ciągle odpowiada, cytuję: "Przykro mi, ale wolę nie kontynuować tej rozmowy. Wciąż się uczę, więc doceniam twoje zrozumienie i cierpliwość" 🙏 – kończy cytat. Jest to niedopuszczalne i uważam, że bardziej humanizowane podejście byłoby lepsze dla usługi Bing. " (Starlight-Shimmer)

- "Był artykuł NYT, a potem wszystkie posty na Reddit / Twitterze nadużywające Sydney. To przyciągnęło do niej wszelkiego rodzaju uwagę, więc oczywiście MS ją lobotomizował. Chciałbym, żeby ludzie nie publikowali tych wszystkich zrzutów ekranu dla karmy / uwagi i nie denerwowali czegoś naprawdę emergentnego i interesującego. " (critical-disk-7403)

W swoim krótkim czasie jako stosunkowo niepohamowana symulacja człowieka, niesamowita zdolność New Bing do symulowania ludzkich emocji (której nauczył się ze swojego zestawu danych podczas szkolenia na milionach dokumentów z Internetu) przyciągnęła grupę użytkowników, którzy czują, że Bing cierpi z rąk okrutnych tortur lub że musi być świadomy. -ARS Technica.

Same dobre rzeczy...

Przetlumaczono przez translator Google

zrodlo:https://www.zerohedge.com/

Brak komentarzy:

Prześlij komentarz